Que faut-il comprendre de BERT ?

Sans rentrer trop dans les détails, autant dire tout de suite que BERT n »a rien à voir avec un prénom du gene Berth ni avec un animal du genre Panda ! Cette fois-ci, on est dans le dur de l’intelligence artificielle et ce qu’elle de plus futuriste mais aussi prometteur.

BERT signifie « Bidirectional Encoder Representations from Transformers ». Hum c’est tout de suite moins ludique mais ça veut dire quoi concrètement ?

BERT en open source depuis 2018

Il faut savoir que BERT ne vient pas de sortir. C’est son utilisation pour le moteur de recherche de Google qui démarre en décembre 2019. BERT est le fruit d’un travail de recherche de longue date pour Google. Travail partagé avec la communauté scientifique autour de la linguistique et l’intelligence artificielle.

Depuis sa publication par Google en 2018, des applications ont été déployées sous différentes formes un peu partout dans le monde et en France avec « CamemBERT » développé par lNRIA.

BERT : l’intelligence artificielle des Transformers combinée à la puissance du Cloud TPU

On savait déjà que Google exploitait des systèmes avancés capables d’analyser des requêtes complexes en faisant appel à l’intelligence artificielle. Knowledge Graph, Rank brain par exemple, ont déjà mis à mal les techniques de sioux des experts SEO croyant pouvoir encore berner le plus puissant moteur de recherche grand public.

En parallèle de faire évoluer son moteur de recherche, Google a pas mal d’autres activités plus ou moins connues et notamment dans les domaines du cloud computing et de l’IA. Les utilisateurs que nous sommes (presque) tous de Google translate constatent les progrès de cet outil. BERT est un des fruits de ces travaux de recherche.

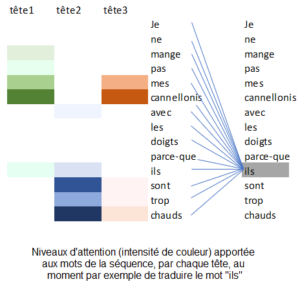

Ce mécanisme combine les capacités d’encodage du langage naturel par les « Transformers » et les capacités de traitement de données des Cloud TPU de Google Cloud Platform. Bidirectionnel signifie que l’algorithme est capable d’analyser une suite de mots du début à la fin et de la fin au début, mot après mot, afin de comprendre le sens de la phrase dans son contexte (je simplifie…). En plus de ça, comme toute intelligence artificielle, BERT apprend et progresse dans sa capacité d’analyse. Le site Lesdieuxducodes.com l’explique très bien et on peut d’ailleurs s’amuser à exploiter BERT soi même en lui apprenant des choses.

Exemple : Je ne peux pas garer ma voiture sur cette place parce-qu’elle est trop petite. <- Ici le pronom personnel « elle » renvoie à la place de parking, pas à la voiture. Il faut une compréhension assez fine de la phrase pour le comprendre. BERT y arrive très bien.

https://lesdieuxducode.com/blog/2019/4/bert–le-transformer-model-qui-sentraine-et-qui-represente

Compris ? Non ? ça n’est pas très grave. L’essentiel est de bien comprendre que cela change assez clairement la philosophie de Google.

BERT ne traite plus seulement des mots clés mais le langage…

On passe en effet un palier dans l’utilisation de l’intelligence artificielle. Jusque là, Rank Brain arrivait à plus ou moins bien reproduire la perception humaine d’un texte sémantiquement riche. Bert est capable d’interpréter un texte et le sens propre somme figuré. Le but est ouvertement assumé de mieux comprendre ce que cherche un internaute par delà les mots utilisés dans le moteur de recherche.

BERT – par l’exploitation ultra rapide des transformers – sait aussi bien traduire qu’interpréter un ensemble de mot et même un texte conséquent de plusieurs dizaines de mots.

Dans l’exemple cité par lesdieuxducode, BERT est capable d’interpréter correctement « avoir la pêche » alors que l’algorithme classique (encore utilisé à ce jour 11/12/2019) renvoie en anglais « to have sin » alors que BERT renverra « feel great ». Cela est possible grâce à des formules complexes qui vont tenir compte du contexte et donner des pondérations aux mots avec plusieurs passages / layers / couches. Bref, BERT analyse d’abord « avoir la pêche ». De part le contexte, les data, l’historique, « avoir la pêche » fait ressortir « feel ». La 2e analyse affine par « great ».

C’est plus clair ? Toujours pas. Bon on est experts SEO pas linguistes spécialisés en IA !

Questions / Réponses à propos de BERT et Google

Chez E-Malaya, on répète depuis 2009 que les contenus de qualité sont la clef de réussite d’un dispositif web – et notamment pour le SEO. Donc BERT ne change pas tant que ça notre position.

Néanmoins, ce qui semble se confirmer est l’exploitation de plus en plus pertinente de l’IA, couplée aux data et la puissance du cloud, le tout quelle que soit la langue. On approche de l’idée de s’adresser à un robot plutôt qu’à un moteur d’indexation. Et comme ce robot apprend et progresse, le contenu qui va permettre de conquérir de bonnes places dans les SERP sera le plus pointu et riche.

Bref, notre seule consigne est de produire des contenus :

- intéressants

- approfondis

- structurés

- en langage naturel

- illustrés

- qui répondent à des besoins d’internautes.

On le savait déjà ? Oui mais de là à l’appliquer réellement, c’est autre chose.

Sans parler de la place du e-commerce là-dedans s’il est encore bienvenue en-dehors du SEA et PLA. En tous cas, on peut tout à fait imaginer BERT aller chercher LE produit qui répond pile à une requête. Les gagnants seront de toute évidence les fiches produits bien renseignées avec une orientation clients et blindées de micro-données !

à suivre…

L’intérêt de BERT réside principalement dans la compréhension du langage naturel par une machine, sa capacité à progresser voire à anticiper les requêtes suivantes.

BERT ne devrait intervenir que sur les requêtes un peu complexes, composées d’une suite de mots voire d’une phrase, d’une question ou d’un texte entier. Cela ne devrait pas toucher plus 10% des requêtes mais – par prudence – je ne m’engagerais pas là-dessus !

- Le mot clé n’a plus beaucoup d’intérêt à lui seul. Son contexte, son historique, son usage sont désormais déterminants.

- Le contexte sémantique pondère le poids des mots clés pour en déceler le sens propre et figuré.

- La logique d’indexation (si on peut encore parler d’index) et de tri des SERP préfigure le web de demain qui devra répondre au langage naturel.

- Les articles, pronoms et autres “petits mots” – ignorés jusque là – ont désormais un poids important surtout s’ils donnent une indication. “de”, “à”, “pour”,

- L’apprentissage de l’algorithme dans une langue pourra être exploitée pour d’autres langues. BERT est couramment multilingue !

Un peu de lecture/sources sur BERT

https://www.blog.google/products/search/search-language-understanding-bert

https://ai.googleblog.com/2018/11/open-sourcing-bert-state-of-art-pre.html

https://cloud.google.com/blog/products/ai-machine-learning/cloud-tpu-pods-break-ai-training-records

https://lesdieuxducode.com/blog/2019/4/bert–le-transformer-model-qui-sentraine-et-qui-represente

https://www.webrankinfo.com/dossiers/google-search/bert